Avanzando hacia un futuro sostenible: Ley de IA en Europa

La Ley de IA representa el primer marco legal global sobre inteligencia artificial (IA), estableciendo directrices para abordar los riesgos asociados con su implementación y posicionando a Europa como líder en este ámbito. El objetivo principal es proporcionar requisitos y obligaciones claros para desarrolladores e implementadores de IA, especialmente en lo que respecta a su uso en aplicaciones específicas. Este marco regulatorio es parte de un conjunto de medidas políticas diseñadas para fomentar el desarrollo de una IA confiable y ética en Europa y en todo el mundo.

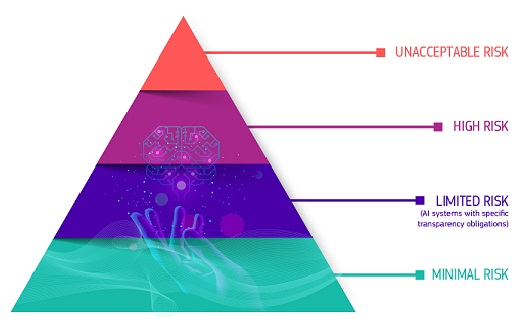

La legislación define cuatro niveles de riesgo para los sistemas de IA:

- Riesgo inaceptable: Se prohíben los sistemas de IA que representen una amenaza clara para la seguridad, los medios de vida y los derechos de las personas. Esto incluye tecnologías como la puntuación social gubernamental o juguetes con asistencia de voz que promuevan comportamientos peligrosos. Tales sistemas no pueden ser comercializados en absoluto.

- Alto riesgo: Los sistemas de IA considerados de alto riesgo, tales como aquellos utilizados en infraestructuras críticas, educación, empleo, servicios públicos esenciales, aplicación de la ley y otros ámbitos, están sujetos a obligaciones estrictas antes de su comercialización. Estas obligaciones incluyen una evaluación y mitigación de riesgos, alta calidad de los conjuntos de datos, registro de actividad para trazabilidad, documentación detallada y supervisión humana adecuada.

- Riesgo limitado: Este nivel de riesgo se refiere a sistemas de IA que no son considerados de alto riesgo, pero aún presentan ciertos riesgos asociados con la falta de transparencia en su uso. La Ley de IA introduce obligaciones específicas de transparencia para estos sistemas, asegurando que los usuarios estén informados sobre la presencia de IA y puedan tomar decisiones informadas al interactuar con ellos. Por ejemplo, en el caso de chatbots, se requiere que los usuarios sean conscientes de que están interactuando con una máquina.

- Riesgo mínimo o nulo: Este nivel de riesgo se aplica a sistemas de IA que presentan riesgos insignificantes o nulos. Incluye aplicaciones como videojuegos con IA o filtros de spam. Estos sistemas tienen menos restricciones y pueden ser utilizados libremente sin necesidad de cumplir con requisitos específicos de la Ley de IA.

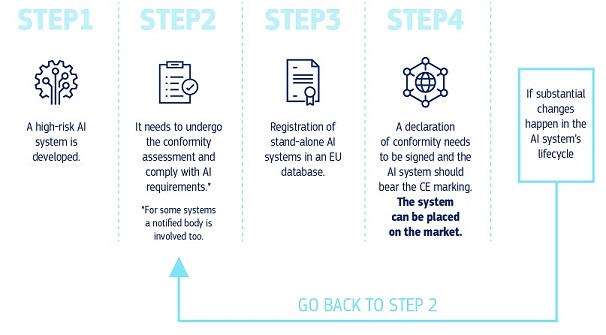

¿Cómo funciona todo en la práctica para los proveedores de sistemas de IA de alto riesgo?

En la práctica, para los proveedores de sistemas de IA de alto riesgo, el proceso se desarrolla de la siguiente manera:

- Una vez que el sistema de IA está en el mercado, las autoridades se encargan de la vigilancia del mercado.

- Los implementadores aseguran la supervisión y seguimiento humanos del sistema.

- Los proveedores tienen un sistema de seguimiento posterior a la comercialización para monitorear el rendimiento y la seguridad del sistema.

- Tanto los proveedores como los implementadores deben informar sobre incidentes graves y mal funcionamiento del sistema.

Confianza en los Sistemas de IA: Desafíos de seguridad y transparencia en los grandes modelos de IA

El uso confiable de grandes modelos de IA se aborda mediante la introducción de la Ley de IA, que impone obligaciones de transparencia y gestión de riesgos. Los modelos de IA de propósito general, cada vez más comunes en los sistemas de IA, poseen capacidades diversas y adaptables, lo que dificulta su supervisión completa. La ley exige transparencia para comprender mejor estos modelos, así como medidas adicionales de gestión de riesgos, como la autoevaluación, la notificación de incidentes graves, evaluaciones de ensayos y modelos, y requisitos de ciberseguridad.

La legislación propuesta para regular la inteligencia artificial (IA) está diseñada con un enfoque adaptable al futuro, reconociendo la rápida evolución de esta tecnología. Se enfoca en garantizar que las aplicaciones de IA permanezcan confiables incluso después de su comercialización, lo que implica mantener una calidad continua y gestionar los riesgos por parte de los proveedores.

Implementación ética de la Ley de IA: Ejecución y próximos pasos para un futuro sostenible

La Oficina Europea de IA, establecida en febrero de 2024, supervisa la implementación de la Ley de IA junto con los Estados miembros, buscando garantizar que las tecnologías de IA respeten la dignidad humana, los derechos y la confianza. Además, promueve la colaboración, la innovación y la investigación en IA y participa en el diálogo internacional sobre cuestiones de IA para posicionar a Europa como líder en el desarrollo ético y sostenible de estas tecnologías. La Ley de IA, acordada políticamente en diciembre de 2023, entrará en vigor y será plenamente aplicable dos años después de su publicación en el Diario Oficial de la UE, con excepciones específicas para diferentes aspectos. Para facilitar la transición al nuevo marco regulatorio, la Comisión ha lanzado el Pacto sobre IA, una iniciativa voluntaria que alienta a los desarrolladores de IA a cumplir con las obligaciones clave de la ley de manera anticipada.